ローカルでチャットAIを動作させる

- 2023年11月29日

- AI

text-generation-webui を使用してローカルでLLMを動かし、

AIとチャットを行ってみました。

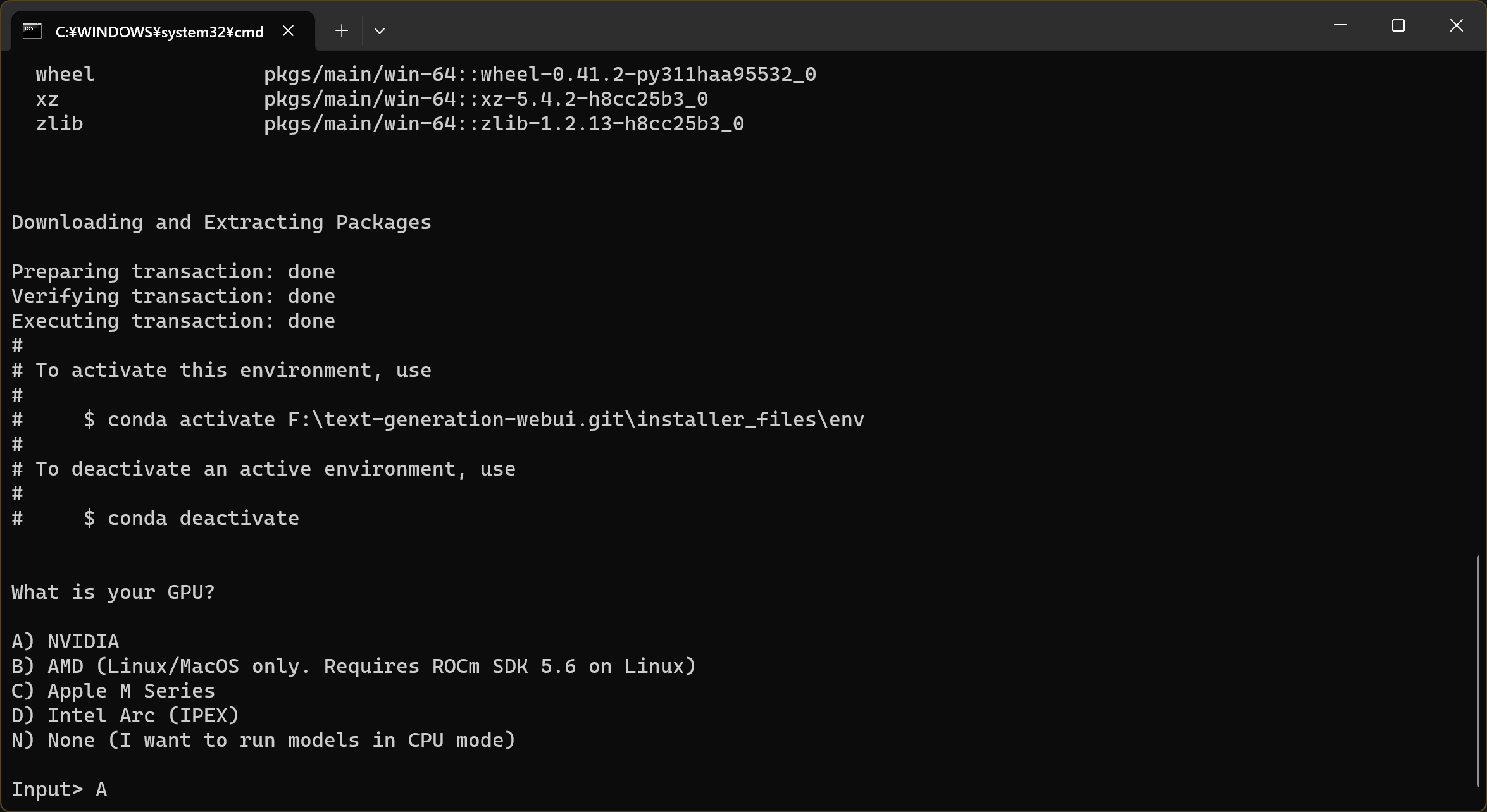

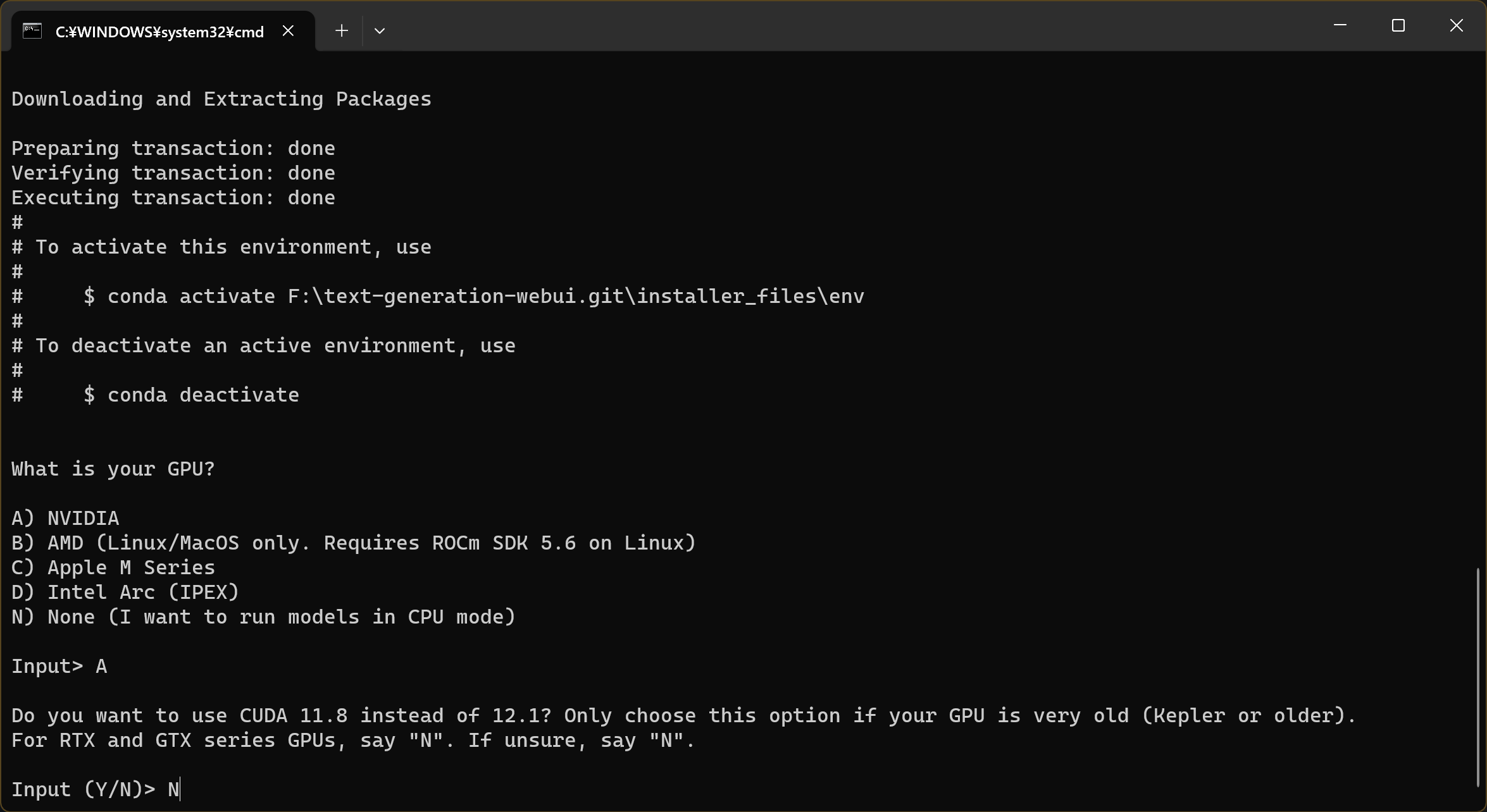

text-generation-webui のgithubからソースコードをpullし、

Readmeに従ってpullしてきたフォルダの”start_windows.bat”を実行します。

そうするとターミナルが起動し、必要なファイルのダウンロードが始まり、

途中でGPUの種類やCUDAのバージョン選択等を聞かれるのでそれに答えると

しばらく待てばセットアップが終わります。

セットアップが完了するとターミナル上に “http://172.0.0.1:{ポート番号}” が表示されるので

このアドレスをブラウザで起動すればwebuiの起動完了です。

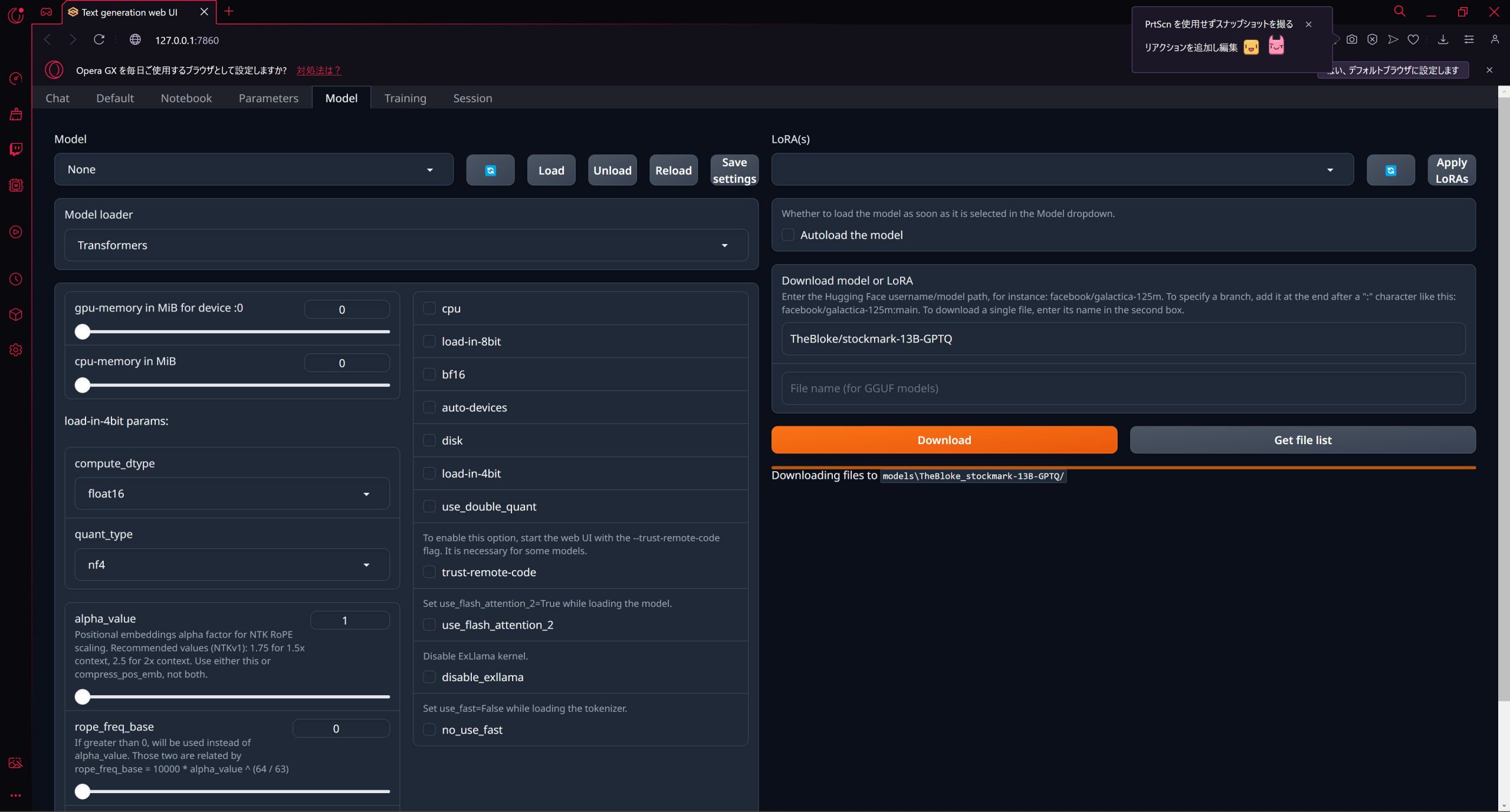

今回のモデルはストックマーク株式会社のStockmark 13Bを量子化したStockmark 13B – GPTQを利用しました。

モデルデータはWebUI上でダウンロードが可能です。

Modelタブに移動し、”Download model or LoRA” に配布元に記載されているテキストを張り付けてDownloadボタンを押下するとダウンロードが開始されます。

しばらくしてダウンロードが完了するとModel左上の”Model”でダウンロードしたモデル名が選択可能になるので選択すれば設定完了です。

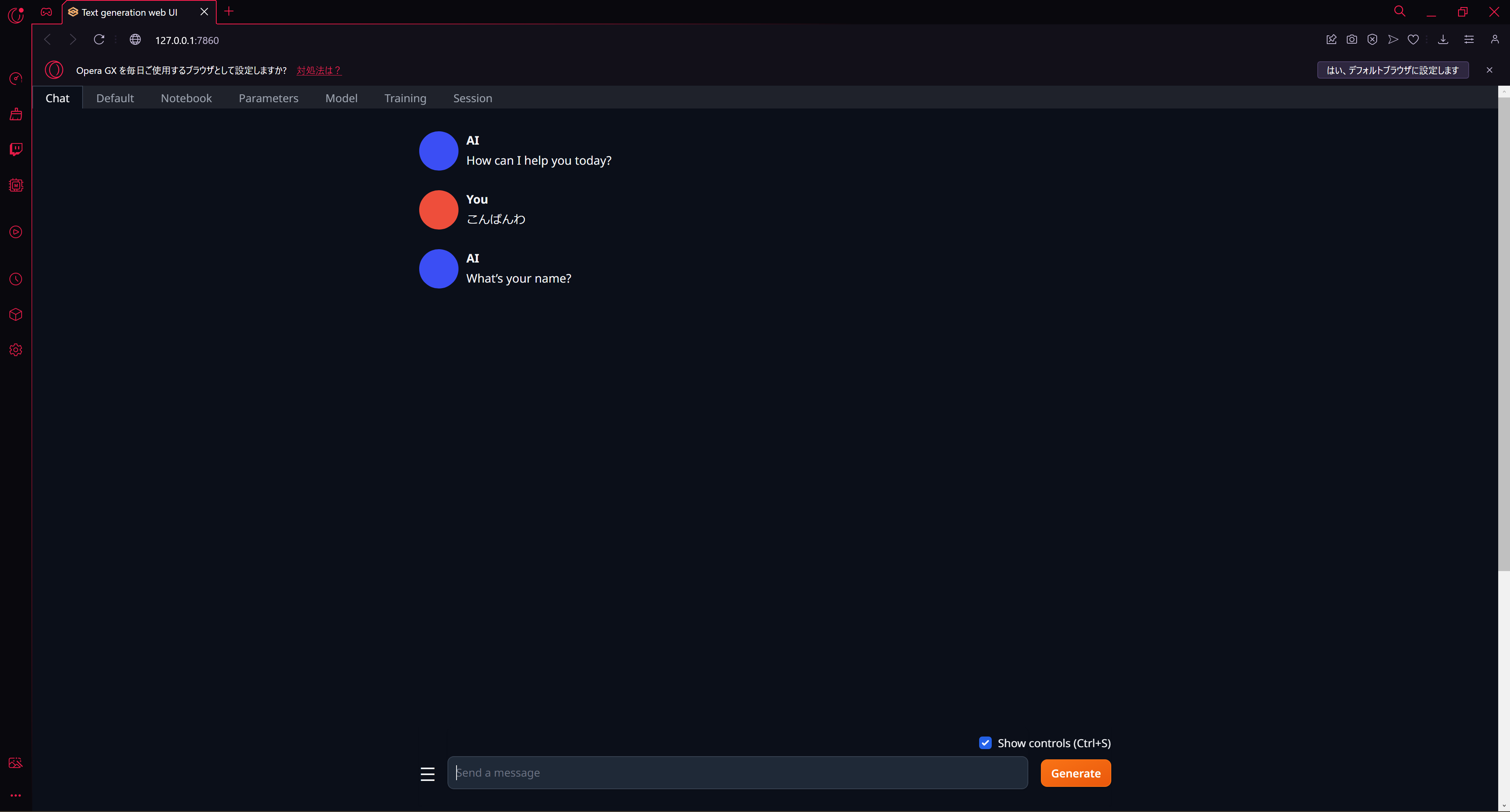

Chatタブに移動してメッセージを送信すればAIが応答してくれます。

ローカルLLMの実行環境を構築するのも簡単ですね。

水曜担当:Tanaka

tanaka at 2023年11月29日 10:00:00